ÕøĀõĖ║ķĪ╣ńø«ńÜäķ£ĆĶ”ü’╝īÕŁ”õ╣ĀõĮ┐ńö©õ║åHadoop’╝īÕÆīµēƵ£ēĶ┐ćńāŁńÜäµŖƵ£»õĖƵĀĘ’╝īŌĆ£Õż¦µĢ░µŹ«ŌĆØŃĆüŌĆ£µĄĘķćÅŌĆØĶ┐Öń▒╗Ķ»ŹĶ»ŁÕ£©õ║ÆĶüöńĮæõĖŖµ╗ĪÕż®õ╣▒ķŻ×ŃĆéHadoopµś»õĖĆõĖ¬ķØ×ÕĖĖõ╝śń¦ĆńÜäÕłåÕĖāÕ╝Åń╝¢ń©ŗµĪåµ×Č’╝īĶ«ŠĶ«Īń▓ŠÕʦĶĆīõĖöńø«ÕēŹµ▓Īµ£ēÕÉīń║¦Õł½ÕÉīķćŹķćÅńÜäµø┐õ╗ŻÕōüŃĆéÕÅ”Õż¢õ╣¤µÄźĶ¦”Õł░õĖĆõĖ¬Õåģķā©õĮ┐ńö©ńÜäµĪåµ×Č’╝īÕ»╣õ║ÄHadoopÕüÜõ║åÕ░üĶŻģÕÆīÕ«ÜÕłČ’╝īõĮ┐ÕŠŚµø┤µ╗ĪĶČ│õĖÜÕŖĪķ£Ćµ▒éŃĆéµłæµ£ĆĶ┐æõ╣¤µā│ÕåÖõĖĆõ║øHadoopńÜäÕŁ”õ╣ĀÕÆīõĮ┐ńö©Õ┐āÕŠŚ’╝īõĮåµś»ń£ŗÕł░ńĮæõĖŖķéŻõ╣łµ│øµ╗źńÜäµ¢ćń½Ā’╝īµłæĶ¦ēÕŠŚÕåŹÕåÖńé╣ń¼öĶ«░õĖƵĀĘńÜäõĖ£Ķź┐Õ«×Õ£©µś»µ▓Īµ£ēõ╗ĘÕĆ╝ŃĆéÕĆÆõĖŹÕ”éÕ£©µ╝½Õż®ķó鵣īńÜ䵌ČÕĆÖÕåĘķØÖõĖŗµØźń£ŗń£ŗ’╝īµ£ēÕō¬õ║øõĖŹķĆéÕÉłHadoopĶ¦ŻÕå│ńÜäķÜŠķóśÕæó’╝¤

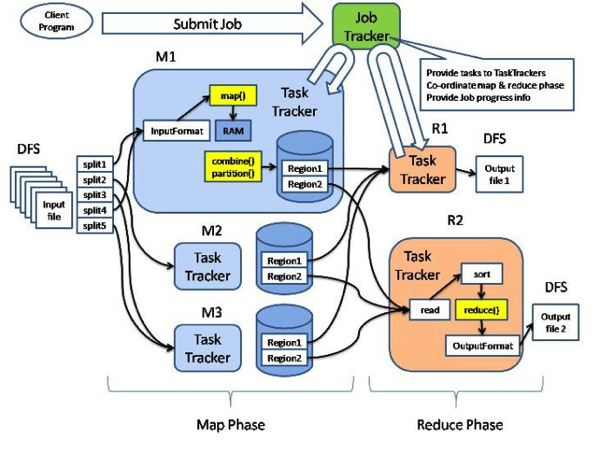

Ķ┐ÖÕ╝ĀÕøŠÕ░▒µś»HadoopńÜäµ×ȵ×äÕøŠ’╝īMapÕÆīReduceµś»õĖżõĖ¬µ£ĆÕ¤║µ£¼ńÜäÕżäńÉåķśČµ«Ą’╝īõ╣ŗÕēŹµ£ēĶŠōÕģźµĢ░µŹ«µĀ╝Õ╝ÅÕ«Üõ╣ēÕÆīµĢ░µŹ«Õłåńēć’╝īõ╣ŗÕÉĵ£ēĶŠōÕć║µĢ░µŹ«µĀ╝Õ╝ÅÕ«Üõ╣ē’╝īõ║īĶĆģõĖŁķŚ┤Ķ┐śÕÅ»õ╗źÕ«×ńÄ░combineĶ┐ÖõĖ¬µ£¼Õ£░reduceµōŹõĮ£ÕÆīpartitionĶ┐ÖõĖ¬ķćŹÕ«ÜÕÉæmapperĶŠōÕć║ńÜäńŁ¢ńĢźĶĪīõĖ║ŃĆéÕÅ»õ╗źÕó×ÕŖĀńÜäÕ«ÜÕłČÕÆīÕó×Õ╝║Õīģµŗ¼’╝Ü

- ĶŠōÕģźµĢ░µŹ«ÕÆīĶŠōÕć║µĢ░µŹ«ńÜäÕ╝║Õī¢’╝īõŠŗÕ”éķĆÜĶ┐ćµĢ░µŹ«ķøåń«ĪńÉåĶĄĘµØź’╝īÕÅ»õ╗źń╗¤õĖĆŃĆüÕÉłÕ╣ČÕÉäÕ╝ŵĢ░µŹ«ķøå’╝īńöÜĶć│õ╣¤ÕÅ»õ╗źń╗ÖµĢ░µŹ«Õó×ÕŖĀĶ┐ćµ╗żµōŹõĮ£õĮ£õĖ║ÕłØńŁø’╝īõ║ŗÕ«×õĖŖõĖÜÕŖĪõĖŖńÜäµĀĖÕ┐āµĢ░µŹ«µ║ɵś»ń¦Źń▒╗ń╣üÕżÜńÜä’╝ø

- µĢ░µŹ«ÕłåńēćńŁ¢ńĢźńÜäµē®Õ▒Ģ’╝īµłæõ╗¼ń╗ÅÕĖĖķ£ĆĶ”üµŖŖÕģĘÕżćµ¤Éõ║øõĖÜÕŖĪÕģ▒µĆ¦ńÜäµĢ░µŹ«µöŠÕł░õĖĆĶĄĘÕżäńÉå’╝ø

- combineÕÆīpartitionńÜäµē®Õ▒Ģ’╝īõĖ╗Ķ”üµś»µ£ēõĖĆõ║øńŁ¢ńĢźÕ«×ńÄ░µś»Õ£©ÕŠłÕżÜHadoopńÜäjobõĖŁķāĮµś»ķĆÜńö©ńÜä’╝ø

- ńøæµÄ¦ÕĘźÕģĘńÜäµē®Õ▒Ģ’╝īĶ┐Öµ¢╣ķØóµłæõ╣¤Ķ¦üĶ┐ćÕł½ńÜäÕģ¼ÕÅĖÕåģķā©Õ«ÜÕłČńÜäÕĘźÕģĘ’╝ø

- ķĆÜĶ«»ÕŹÅĶ««ÕÆīµ¢ćõ╗Čń│╗ń╗¤ńÜäÕó×Õ╝║’╝īÕ░żÕģȵś»µ¢ćõ╗Čń│╗ń╗¤’╝īµ£ĆÕźĮĶāĮńö©ĶĄĘµØźÕāÅµÄźĶ┐æµ£¼Õ£░ÕæĮõ╗żõĖƵĀĘ’╝īĶ┐ÖµĀĘńÜäÕ«ÜÕłČÕ£©õ║ÆĶüöńĮæõĖŖõ╣¤ĶāĮµēŠÕŠŚÕł░’╝ø

- µĢ░µŹ«Ķ«┐ķŚ«ńÜäń╝¢ń©ŗµÄźÕÅŻńÜäĶ┐øõĖƵŁźÕ░üĶŻģ’╝īõĖ╗Ķ”üõ╣¤µś»õĖ║õ║åµø┤ÕłćÕÉłõĖÜÕŖĪ’╝īńö©ńØƵ¢╣õŠ┐’╝ø

- ŌĆ”ŌĆ”

Ķ┐Öõ║øÕ«ÜÕłČõ╗ĵ¤Éń¦Źń©ŗÕ║”õĖŖõ╣¤ÕÅŹÕ║öõ║åHadoopÕ£©Õ«×ķÖģõĮ┐ńö©õĖŁńĢźµä¤Õ▒ĆķÖɵł¢ĶĆģĶ«ŠĶ«ĪµŚČµŚĀµÜćķĪŠÕÅŖńÜäÕ£░µ¢╣’╝īõĮåµś»Ķ┐Öõ║øķāĮµś»Õ░ÅķŚ«ķóś’╝īķāĮµś»ķĆÜĶ┐ćÕ«ÜÕłČÕÆīµē®Õ▒ĢĶāĮÕż¤õ┐«ÕżŹńÜäŃĆéõĮåµś»µ£ēõĖĆõ║øķŚ«ķóś’╝īµś»HadoopÕż®ńö¤µŚĀµ│ĢĶ¦ŻÕå│ńÜä’╝īµł¢ĶĆģĶ»┤’╝īµś»õĖŹķĆéÕÉłõĮ┐ńö©HadoopµØźĶ¦ŻÕå│ńÜäķŚ«ķóśŃĆé

1ŃĆüµ£Ćµ£ĆķćŹĶ”üõĖĆńé╣’╝īHadoopĶāĮĶ¦ŻÕå│ńÜäķŚ«ķóśÕ┐ģķĪ╗µś»ÕÅ»õ╗źMapReduceńÜäŃĆéĶ┐Öķćīµ£ēõĖżõĖ¬ńē╣Õł½ńÜäÕɽõ╣ē’╝īõĖĆõĖ¬µś»ķŚ«ķóśÕ┐ģķĪ╗ÕÅ»õ╗źµŗåÕłå’╝īµ£ēńÜäķŚ«ķóśń£ŗĶĄĘµØźÕŠłÕż¦’╝īõĮåµś»µŗåÕłåÕŠłÕø░ķÜŠ’╝øń¼¼õ║īõĖ¬µś»ÕŁÉķŚ«ķóśÕ┐ģķĪ╗ńŗ¼ń½ŗŌĆöŌĆöÕŠłÕżÜHadoopńÜäµĢÖµØÉõĖŖķØóķāĮõĖŠõ║åõĖĆõĖ¬µ¢Éµ│óķéŻÕźæµĢ░ÕłŚńÜäõŠŗÕŁÉ’╝īµ»ÅõĖƵŁźµĢ░µŹ«ńÜäĶ┐Éń«ŚķāĮõĖŹµś»ńŗ¼ń½ŗńÜä’╝īķāĮÕ┐ģķĪ╗õŠØĶĄ¢õ║ÄÕēŹõĖƵŁźŃĆüÕēŹõ║īµŁźńÜäń╗ōµ×£’╝īµŹóĶ©Ćõ╣ŗ’╝īµŚĀµ│ĢµŖŖÕż¦ķŚ«ķóśÕłÆÕłåµłÉńŗ¼ń½ŗńÜäÕ░ÅķŚ«ķóś’╝īĶ┐ÖµĀĘńÜäÕ£║µÖ»µś»µĀ╣µ£¼µ▓Īµ£ēÕŖ×µ│ĢõĮ┐ńö©HadoopńÜäŃĆé

2ŃĆüµĢ░µŹ«ń╗ōµ×äõĖŹµ╗ĪĶČ│key-valueĶ┐ÖµĀĘńÜ䵩ĪÕ╝ÅńÜäŃĆéÕ£©Hadoop In ActionõĖŁ’╝īõĮ£ĶĆģµŖŖHadoopÕÆīÕģ│ń│╗µĢ░µŹ«Õ║ōÕüÜõ║åµ»öĶŠā’╝īń╗ōµ×äÕī¢µĢ░µŹ«µ¤źĶ»óµś»õĖŹķĆéÕÉłńö©HadoopµØźÕ«×ńÄ░ńÜä’╝łĶÖĮńäČÕāÅHiveĶ┐ÖµĀĘńÜäõĖ£Ķź┐µ©Īµŗ¤õ║åANSI SQLńÜäĶ»Łµ│Ģ’╝ēŃĆéÕŹ│õŠ┐Õ”éµŁż’╝īµĆ¦ĶāĮÕ╝ĆķöĆõĖŹµś»õĖĆĶł¼Õģ│ń│╗µĢ░µŹ«Õ║ōÕÅ»õ╗źµ»öµŗ¤ńÜä’╝īĶĆīÕ”éµ×£µś»ÕżŹµØéõĖĆńé╣ńÜäń╗äÕÉłµØĪõ╗ČńÜ䵤źĶ»ó’╝īĶ┐śµś»õĖŹÕ”éSQLńÜäÕ©üÕŖøÕ╝║Õż¦ŃĆéń╝¢ÕåÖõ╗ŻńĀüĶ░āńö©õ╣¤µś»ÕŠłĶŖ▒Ķ┤╣µŚČķŚ┤ńÜäŃĆé

3ŃĆüHadoopõĖŹķĆéÕÉłńö©µØźÕżäńÉåÕż¦µē╣ķćÅńÜäÕ░ŵ¢ćõ╗ČŃĆéÕģČÕ«×Ķ┐Öµś»ńö▒namenodeńÜäÕ▒ĆķÖɵƦµēĆÕå│Õ«ÜńÜä’╝īÕ”éµ×£µ¢ćõ╗ČĶ┐ćÕ░Å’╝īnamenodeÕŁśÕé©ńÜäÕģāõ┐Īµü»ńøĖÕ»╣µØźĶ»┤Õ░▒õ╝ÜÕŹĀńö©Ķ┐ćÕż¦µ»öõŠŗńÜäń®║ķŚ┤’╝īÕåģÕŁśĶ┐śµś»ńŻüńøśÕ╝ĆķöĆķāĮķØ×ÕĖĖÕż¦ŃĆéÕ”éµ×£õĖƵ¼ĪtaskńÜäµ¢ćõ╗ČÕżäńÉåĶŠāÕż¦’╝īķéŻõ╣łĶÖܵŗ¤µ£║ÕÉ»ÕŖ©ŃĆüÕłØÕ¦ŗÕī¢ńŁēńŁēÕćåÕżćµŚČķŚ┤ÕÆīõ╗╗ÕŖĪÕ«īµłÉÕÉÄńÜäµĖģńÉåµŚČķŚ┤’╝īńöÜĶć│shuffleńŁēńŁēµĪåµ×ȵȳĶĆŚµŚČķŚ┤µēĆÕŹĀńÜäµ»öõŠŗÕ░▒Õ░ÅÕŠŚÕżÜ’╝øÕÅŹõ╣ŗ’╝īÕżäńÉåńÜäÕÉ×ÕÉÉķćÅÕ░▒µÄēõĖŗµØźõ║åŃĆé’╝łµ£ēõ║║ÕüÜõ║åõĖĆõĖ¬Õ«×ķ¬ī’╝īÕÅéķśģ’╝ÜķōŠµÄź’╝ē

4ŃĆüHadoopõĖŹķĆéÕÉłńö©µØźÕżäńÉåķ£ĆĶ”üÕÅŖµŚČÕōŹÕ║öńÜäõ╗╗ÕŖĪ’╝īķ½śÕ╣ČÕÅæĶ»Ęµ▒éńÜäõ╗╗ÕŖĪŃĆéĶ┐Öõ╣¤ÕŠłÕ«╣µśōńÉåĶ¦Ż’╝īõĖŖķØóÕĘ▓ń╗ÅĶ»┤õ║åĶÖܵŗ¤µ£║Õ╝ĆķöĆŃĆüÕłØÕ¦ŗÕī¢ÕćåÕżćµŚČķŚ┤ńŁēńŁē’╝īÕŹ│õĮ┐taskķćīķØóõ╗Ćõ╣łķāĮõĖŹÕüÜÕ«īµĢ┤Õ£░ĶĘæõĖĆķüŹjobõ╣¤Ķ”üĶŖ▒Ķ┤╣ÕćĀÕłåķƤµŚČķŚ┤ŃĆé

5ŃĆüHadoopĶ”üÕżäńÉåń£¤µŁŻńÜäŌĆ£Õż¦µĢ░µŹ«ŌĆØ’╝īµŖŖscale upń£¤µŁŻÕÅśµłÉscale out’╝īõĖżÕÅ░Õ░ÅńĀ┤µ£║ÕÖ©’╝īµł¢ĶĆģÕćĀŃĆüÕŹüÕćĀGBĶ┐Öń¦ŹµĢ░µŹ«ķćÅ’╝īńö©HadoopÕ░▒µśŠÕŠŚń▓Śń¼©õ║åŃĆéÕ╝鵣źń│╗ń╗¤µ£¼Ķ║½ńÜäńø┤Ķ¦éµĆ¦Õ╣ČõĖŹÕāÅķéŻõ║øÕÉīµŁźń│╗ń╗¤µØźÕŠŚÕźĮ’╝īĶ┐Öµś»µśŠĶĆīµśōĶ¦üńÜäŃĆéµēĆõ╗źÕ¤║µ£¼õĖŖµØźĶ»┤’╝īń╗┤µŖżµłÉµ£¼õĖŹõ╝ÜõĮÄŃĆé

µ¢ćń½Āń│╗µ£¼õ║║ÕÄ¤Õłø’╝īĶĮ¼ĶĮĮĶ»Ęõ┐صīüÕ«īµĢ┤µĆ¦Õ╣ȵ│©µśÄÕć║Ķć¬ŃĆŖÕøøńü½ńÜäÕöĀÕÅ©ŃĆŗ

ńøĖÕģ│µÄ©ĶŹÉ

µ¢ćń½Āńø«ÕĮĢĶ¦ŻÕå│ÕŖ×µ│Ģ1’╝ÜĶ¦ŻÕå│ÕŖ×µ│Ģ2’╝ÜĶ¦ŻÕå│ÕŖ×µ│Ģ3’╝ÜĶ¦ŻÕå│ÕŖ×µ│Ģ4’╝ÜĶ¦ŻÕå│ÕŖ×µ│Ģ5’╝Ü Ķ¦ŻÕå│ÕŖ×µ│Ģ1’╝Ü õ┐«µö╣selinux [root@djt002 hadoop]# vi /etc/selinux/config Ķ¦ŻÕå│ÕŖ×µ│Ģ2’╝Ü µ¤źń£ŗõĮĀńÜä$HADOOP_HOME/etc/hadoopõĖŗńÜäcore-site.xmlÕÆī...

hadoop ÕÉ»ÕŖ©µŚČ TaskTrackerµŚĀµ│ĢÕÉ»ÕŖ© ERROR org.apache.hadoop.mapred.TaskTracker: Can not start task tracker because java.io.IOException: Failed to set permissions of path: \tmp\hadoop-admin \mapred\...

win10õĖŗhadoop2.7.2Õ«ēĶŻģÕīģÕÅŖhadoop.dllÕÆīwinutils.exe’╝īĶ¦ŻÕå│win10õĖŗÕ«ēĶŻģhadoopµŚĀµ│ĢõĮ┐ńö©ķŚ«ķóś

hadoopķøåńŠżµÉŁÕ╗║ķ½śÕÅ»ńö©µ¢ćµĪŻÕ£©Hadoop2.xõ╣ŗÕÉÄńÜäńēłµ£¼’╝īµÅÉÕć║õ║åĶ¦ŻÕå│ÕŹĢńé╣ķŚ«ķóśńÜäµ¢╣µĪł’╝Ź’╝ŹHA’╝łHigh Available ķ½śÕÅ»ńö©’╝ēŃĆéĶ┐Öń»ćÕŹÜÕ«óķśÉĶ┐░Õ”éõĮĢµÉŁÕ╗║ķ½śÕÅ»ńö©ńÜäHDFSÕÆīYARN’╝īµē¦ĶĪīµŁźķ¬żÕ”éõĖŗ’╝Ü ÕłøÕ╗║hadoopńö©µłĘ Õ«ēĶŻģJDK ķģŹńĮ«hosts Õ«ēĶŻģSSH ...

SparkńÜäÕ┤øĶĄĘÕ»╣õĮ£õĖ║ÕĮōÕēŹµ£ĆõĖ║µĄüĶĪīńÜäÕż¦µĢ░µŹ«ķŚ«ķóśĶ¦ŻÕå│µ¢╣µĪłńÜäHadoopÕÅŖÕģČńö¤µĆüń│╗ń╗¤ÕĮóµłÉõ║åµ£ēÕŖøńÜäÕå▓Õć╗’╝īńöÜĶć│õĖĆÕ║”µ£ēõ║║Ķ«żõĖ║Sparkµ£ēÕÅ¢õ╗ŻHadoopńÜäĶČŗÕŖ┐’╝īõĮåµś»ÕøĀõĖ║HadoopõĖÄSparkµ£ēńØĆÕÉäĶć¬õĖŹÕÉīńÜäńē╣ńé╣’╝īõĮ┐ÕŠŚõĖżĶĆģµŗźµ£ēõĖŹÕÉīńÜäÕ║öńö©Õ£║µÖ»’╝ī...

Õģ│õ║ÄhadoopķøåńŠżńÜäµÉŁÕ╗║’╝īĶ»”ń╗åĶ«▓Ķ┐░õ║åÕ”éõĮĢµÉŁÕ╗║ķøåńŠż’╝īķģŹńĮ«µ¢ćõ╗Čõ╗źÕÅŖÕ”éõĮĢÕÉ»ÕŖ©’╝īĶ┐śµ£ēÕÅ»ĶāĮķüćÕł░ńÜäķŚ«ķóśõ╗źÕÅŖĶ¦ŻÕå│µ¢╣µĪł

Hadoop datanodeķ揵¢░ÕŖĀĶĮĮÕż▒Ķ┤źµŚĀµ│ĢÕÉ»ÕŖ©Ķ¦ŻÕå│.docx

macńēłµ£¼’╝īĶ¦ŻÕå│hadoop2.0+Õ«ēĶŻģÕÉĵŚĀµ│ĢÕŖĀĶĮĮµ£¼Õ£░Õ║ōńÜäķŚ«ķóś’╝łµŚĀµ│ĢÕŖĀĶĮĮnativeÕ║ō’╝ēõĖ╗Ķ”üÕĤÕøĀµś»Õ«śńĮæķóäń╝¢Ķ»æńÜäõĖŹµö»µīümacOSń│╗ń╗¤’╝īķ£ĆĶ”üµłæõ╗¼Ķć¬ĶĪīń╝¢Ķ»æ

Õł®ńö©JPAÕüÜŌĆ£Õģ¼Õģ▒ķ╗æµØ┐ŌĆØ’╝īĶ¦ŻÕå│õ║åµĢ░µŹ«µī¢µÄśõĖŁhadoopńÜäÕŁÉõ╗╗ÕŖĪµŚĀµ│ĢÕģ▒õ║½µĢ░µŹ«ńÜäķŚ«ķóś’╝īµÅÉÕć║õ║åµĀæÕ×ŗń╗ōµ×äńÜäķ½śµĢłń«Śµ│ĢŃĆéÕģĘõĮōÕ«×ńÄ░õ║åkdtreeńÜähadoopńēłµ£¼ŃĆé õ╗ŻńĀüÕÅ»õ╗źÕ£©...

ńøĖõ┐ĪÕ»╣õ║ÄÕż¦ķā©ÕłåńÜäÕż¦µĢ░µŹ«ÕłØÕŁ”ĶĆģµØźĶ»┤’╝īõĖĆÕ«ÜķüćĶ¦üĶ┐ćhadoopķøåńŠżµŚĀµ│ĢµŁŻÕĖĖÕģ│ķŚŁńÜäµāģÕåĄŃĆéµ£ēµŚČÕĆÖÕĮōµłæõ╗¼µø┤µö╣õ║åhadoopÕåģń╗äõ╗ČńÜäķģŹńĮ«µ¢ćõ╗ČÕÉÄ’╝īÕ┐ģķĪ╗Ķ”üķĆÜĶ┐ćķćŹÕÉ»ķøåńŠżµØźõĮ┐ķģŹńĮ«µ¢ćõ╗Čńö¤µĢłŃĆé ┬ĀõĮåÕŠĆÕŠĆõĖĆstop-all.sh,ķøåńŠżõĖŗµ¢╣µĆ╗õ╝ÜÕć║ńÄ░õĖŗķØóńÜä...

Õł®ńö©µīüõ╣ģÕī¢µ¢╣µ│Ģ’╝łJPA’╝ē’╝īĶ¦ŻÕå│õ║åHadoopńÜäÕŁÉõ╗╗ÕŖĪµŚĀµ│ĢÕģ▒õ║½µĢ░µŹ«ńÜäķŚ«ķóś’╝īµÅÉÕć║õ║åõĖĆõĖ¬hadoopõĖŖńÜäµĢ░µŹ«µī¢µÄśµĪåµ×Č’╝īÕÅ»õ╗źÕ«īµłÉµĀæÕ×ŗń╗ōµ×äŃĆéÕģĘõĮōÕ«×ńÄ░õ║åDBtreeŃĆé õĖŗķØ󵜻risµĀ╝Õ╝ÅńÜäÕ╝Ģµ¢ć’╝īÕŁśńøśÕÉÄ’╝īÕÅ»õĖ║endnoteńŁēµ¢ćńī«ń«ĪńÉåĶĮ»õ╗ČÕ»╝ÕģźŃĆé TY ...

Ķ¦ŻÕå│hadoopÕ£©windowõĖŗjobtracerµŚĀµ│ĢÕÉ»ÕŖ©ńÜäķŚ«ķóś’╝īÕÅ»õ╗źÕ£©logõĖŁµ¤źń£ŗ

macńēłµ£¼’╝īĶ¦ŻÕå│hadoop3.0.0Õ«ēĶŻģÕÉĵŚĀµ│ĢÕŖĀĶĮĮµ£¼Õ£░Õ║ōńÜäķŚ«ķóś

1.1 ..................................................................................................4 õ╗Ćõ╣łµś»Hadoop’╝¤ 1.2 ................................................................................

Õ░Įń«ĪķĆēµŗ®õ┐«µö╣ń╗äńŁ¢ńĢźõĖŁńÜäµ£¼Õ£░Õ«ēÕģ©ńŁ¢ńĢź...ÕøĀµŁż’╝īķĆÜĶ┐ćõ┐«µö╣winutilsµ║ÉńĀüÕ╣Čń╝¢Ķ»æµłÉÕŖ¤’╝īĶ¦ŻÕå│õ║åµŚĀµ│Ģńö¤µłÉń¼”ÕÅĘķōŠµÄźĶ┐ÖõĖ¬Õ«ēÕģ©µĆ¦ķŚ«ķóś’╝īń╗ÅĶ┐ćÕ«×µĄŗ’╝īÕĤµØźµŖźķöÖńÜäsymblink’╝ł1’╝ēõĖŹÕåŹÕÅæńö¤ŃĆéµø┐µŹóµ£¼ńø«ÕĮĢõĖŗńÜäµ¢ćõ╗ČÕÉÄ’╝īyarnÕÅŖsqoopÕØćĶāĮµŁŻńĪ«Ķ┐ÉĶĪīŃĆé

ÕĮōhdfsÕć║ńÄ░õĖŹÕ╣│ĶĪĪńŖČÕåĄńÜ䵌ČÕĆÖ’╝īÕ░åÕ╝ĢÕÅæÕŠłÕżÜķŚ«ķóś’╝īµ»öÕ”éMRń©ŗÕ║ŵŚĀµ│ĢÕŠłÕźĮÕ£░Õł®ńö©µ£¼Õ£░Ķ«Īń«ŚńÜäõ╝śÕŖ┐’╝īµ£║ÕÖ©õ╣ŗķŚ┤µŚĀµ│ĢĶŠŠÕł░µø┤ÕźĮńÜäńĮæń╗£ÕĖ”Õ«ĮõĮ┐ńö©ńÄć’╝īµ£║ÕÖ©ńŻüńøśµŚĀµ│ĢÕł®ńö©ńŁēńŁēŃĆéÕøĀõĖÜÕŖĪķ£ĆĶ”üµÉŁÕ╗║õĖĆõĖ¬µ¢░hadoopķøåńŠż’╝īÕ╣ČÕ░åĶĆüńÜähadoopķøåńŠżõĖŁńÜä...

ńäČĶĆīõ╗żõ║║µŚĀÕźłńÜ䵜»’╝īÕĮōõĮ┐ńö©õĖƵ¢╣õĮ£õĖ║µĢ░µŹ«µ║ɵŚČ’╝īµłæõ╗¼µŚĀµ│Ģõ╗ÄÕÅ” õĖƵ¢╣Ķć¬ńö▒Õ£░Ķ┐øĶĪīµ¤źĶ»óŃĆéń╗łõ║ÄÕ£©Hadoop 0.19 ńēłµ£¼µŚČ’╝īµ¢░Õó×ńÜäDBInputFormat ń╗äõ╗ČÕÅ»õ╗źĶĮ╗µØŠÕ£░ Õ£©Hadoop õĖÄĶ«ĖÕżÜÕģ│ń│╗Õ×ŗµĢ░µŹ«Õ║ōõ╣ŗķŚ┤Õ»╝ÕģźÕ»╝Õć║µĢ░µŹ«ŃĆéõĖĵŁżÕÉīµŚČ’╝īĶ«ĖÕżÜń¼¼õĖē...

ķģŹÕźŚĶĄäµ║É’╝īµ£¼õ║║Ķć¬ÕĘ▒µÉŁÕ╗║ńÜähadoopĶ┐ćń©ŗÕĖĖĶ¦üķŚ«ķóś’╝Ü Q’╝ÜÕ╝ĆÕ¦ŗµŚČµŚĀµ│ĢÕłøÕ╗║ĶÖܵŗ¤µ£║’╝īń│╗ń╗¤µÅÉńż║õĖŹµö»µīüCPUĶÖܵŗ¤Õī¢ŃĆé A;Ķüöµā│µ£║ÕÖ©ÕĖĖĶ¦üķŚ«ķóś’╝īńÖŠÕ║”õĖĆõĖŗÕ░▒ÕÅ»õ╗źõ║åŃĆéĶ┐øÕģźBIOSĶ«ŠńĮ«õĖĆõĖŗ’╝īķćŹÕÉ»ÕŹ│ÕÅ»Ķ¦ŻÕå│ŃĆé Q’╝ܵ▓ĪńĮæń╗£ŃĆé A’╝ܵ¢░µēŗÕĖĖĶ¦üķŚ«ķóśŃĆé...