µ£ĆĶ┐æÕ£©ÕåÖõĖĆõĖ¬ń©ŗÕ║Å’╝īÕÄ╗ńł¼ńāŁķŚ©õ║ŗõ╗ČÕÆīńāŁķŚ©Õģ│ķö«Ķ»ŹńĮæń½ÖõĖŖńÜäµĢ░µŹ«ŃĆéÕ£©Ķ┐Öķćīõ╗ŗń╗ŹõĖĆõĖŗńĮæń╗£ńł¼ĶÖ½ńÜäń¦Źń¦ŹŃĆé

Õ¤║µ£¼ń╗äõ╗Č

ńĮæń╗£ńł¼ĶÖ½õ╣¤ÕŽÕüÜńĮæń╗£Ķ£śĶøø’╝īµś»õĖĆń¦Źõ║ÆĶüöńĮæµ£║ÕÖ©õ║║’╝īµŖŖķ£ĆĶ”üńÜäńĮæķĪĄµÆĘÕÅ¢õĖŗµØź’╝īń╗äń╗浳ÉķĆéÕĮōµĀ╝Õ╝ÅÕŁśÕé©ŃĆéÕ«āµś»µÉ£ń┤óÕ╝ĢµōÄńÜäķćŹĶ”üń╗䵳Éķā©Õłå’╝īĶÖĮńäČõ╗ĵŖƵ£»Õ«×ńÄ░õĖŖµØźĶ»┤’╝īÕ«āńÜäķÜŠÕ║”ÕŠĆÕŠĆĶ”üÕ░Åõ║ÄÕ»╣õ║ÄÕŠŚÕł░ńÜäńĮæķĪĄõ┐Īµü»ńÜäÕżäńÉåŃĆé

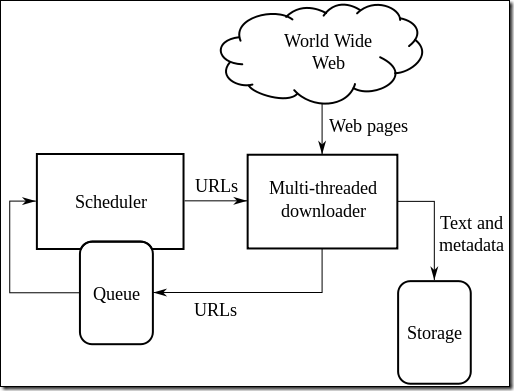

õĖŖķØóĶ┐ÖÕ╝ĀÕøŠµØźĶć¬ń╗┤Õ¤║ńÖŠń¦æ’╝īschedulerĶ░āÕ║”ÕżÜõĖ¬ÕżÜń║┐ń©ŗńÜäõĖŗĶĮĮÕÖ©õĖŗĶĮĮńĮæķĪĄ’╝īÕ╣ȵŖŖõ┐Īµü»ÕÆīÕģāµĢ░µŹ«ÕŁśÕé©ĶĄĘµØźŃĆéĶĆīķĆÜĶ┐ćĶ¦Żµ×ÉõĖŗĶĮĮńĮæķĪĄńÜäµĢ░µŹ«’╝īµēŠÕł░ķōŠµÄź’╝īÕÅłµŖŖķōŠµÄźÕŖĀÕģźÕł░ÕĘźõĮ£ķś¤ÕłŚõĖŁÕÄ╗ÕćåÕżćõĖŗĶĮĮŃĆéĶ┐Öń£ŗĶĄĘµØźµś»õĖĆõĖ¬Ķ┐Łõ╗ŻńÜäĶ┐ćń©ŗŃĆé

ńĮæń╗£ńł¼ĶÖ½ńøĖÕģ│ńÜäÕćĀķĪ╣ķćŹĶ”üńŁ¢ńĢź’╝Ü

- ķĆēµŗ®ńŁ¢ńĢź’╝ÜÕō¬õ║øńĮæķĪĄµś»ķ£ĆĶ”üĶó½µŖōÕÅ¢ńÜä’╝ø

- ķćŹĶ«┐ķŚ«ńŁ¢ńĢź’╝ܵĆĵĀĘńÜäµ¢╣Õ╝ÅÕÄ╗µŻĆµĄŗńĮæķĪĄµś»ÕÉ”Ķó½õ┐«µö╣Ķ┐ć’╝ø

- ńż╝Ķ▓īµĆ¦ńŁ¢ńĢź’╝ܵŖōÕÅ¢ńĮæķĪĄńÜ䵌ČÕĆÖ’╝īķ£ĆĶ”üµ¢╣Õ╝ÅńĮæń½ÖĶ┐ćĶĮĮ’╝ø

- Õ╣ČĶĪīÕī¢ńŁ¢ńĢź’╝ܵĆĵĀĘń╗äń╗ćÕłåÕĖāÕ╝ÅńÜäńĮæń╗£ńł¼ĶÖ½ŃĆé

ķĆēµŗ®ńŁ¢ńĢź

ķÖÉÕ«ÜĶʤķÜÅķōŠµÄźŃĆéķĆÜÕĖĖÕŬķ£ĆĶ”ühtmlµ¢ćµ£¼õ┐Īµü»’╝īµēĆõ╗źµĀ╣µŹ«MIMEń▒╗Õ×ŗ’╝īÕ”éµ×£õĖŹµś»µ¢ćµ£¼õ┐Īµü»’╝īõ╝ÜĶó½õĖóÕ╝āµÄēŃĆéµēĆõ╗ź’╝īÕ”éµ×£URLµŚĀµ│ĢÕŠŚń¤źĶĄäµ║ÉńÜäõ║īĶ┐øÕłČń▒╗Õ×ŗ’╝īńł¼ĶÖ½ÕÅ»ĶāĮõ╝ÜÕģłÕÅæĶĄĘõĖĆõĖ¬headĶ»Ęµ▒éĶÄĘń¤źńø«µĀ浜»õĖŹµś»µ¢ćµ£¼’╝īÕ”éµ×£µś»ńÜäĶ»Ø’╝īµēŹÕÅæķĆüõĖĆõĖ¬getĶ»Ęµ▒éĶÄĘÕÅ¢ķĪĄķØóŃĆé

URLµĀćÕćåÕī¢ŃĆéÕ«āńö©µØźķü┐ÕģŹÕżÜµ¼Īńł¼Õł░ńøĖÕÉīńÜäķĪĄķØóŃĆéµ£ēõ║øURLÕīģÕɽŌĆ£../ŌĆØĶ┐ÖµĀĘńÜäńøĖÕ»╣ĶĘ»ÕŠäõ┐Īµü»’╝īĶ┐Öõ╣¤ķ£ĆĶ”üńł¼ĶÖ½ÕżäńÉåõĮ┐õ╣ŗµłÉõĖ║Õ«īµĢ┤µŁŻńĪ«ńÜäURL’╝īĶĆīµ£ēõ║øURLÕłÖķ£ĆĶ”üÕ£©µ£ĆÕÉÄķØóÕŖĀõĖŖµ¢£µØĀŃĆé

ĶĘ»ÕŠäÕŹćÕ║ÅŃĆéµ£ēõ║øńł¼ĶÖ½µā│Õ░ĮÕÅ»ĶāĮńł¼ÕżÜńÜäõ┐Īµü»’╝īĶĄäµ║ɵś»µ£ēÕ▒éń║¦Õģ│ń│╗ńÜä’╝īµ»öÕ”éhttp://llama.org/hamster/monkey/page.htmlĶ┐ÖµĀĘõĖĆõĖ¬ķōŠµÄź’╝īÕ«āõ╝ÜÕ░ØĶ»Ģńł¼ŌĆ£/hamster/monkey/ŌĆØŃĆüŌĆ£/hamster/ŌĆØÕÆīŌĆ£/ŌĆØĶ┐ÖÕćĀõĖ¬ķĪĄķØóŃĆé

ÕŁ”µ£»ńĮæķĪĄńł¼ĶÖ½ŃĆéõĖōµ│©õ║ÄÕŁ”µ£»ķóåÕ¤¤’╝īµ»öÕ”éGoogle ScholarńŁēńŁēŃĆé

ķćŹĶ«┐ķŚ«ńŁ¢ńĢź

ńĮæķĪĄµĆ╗µś»Õ£©ÕŖ©µĆüÕÅśÕī¢ńÜä’╝īńł¼Õ«īµĢ┤õĖĆõĖ¬ńĮæń½ÖÕÅ»ĶāĮõ╝ÜĶŖ▒µÄēµĢ░Õæ©ńöÜĶć│õĖĆõĖ¬µ£łńÜ䵌ČķŚ┤’╝īÕ£©ńł¼Õ«īõĖĆõĖ¬ńĮæķĪĄõ╣ŗÕÉÄ’╝īńĮæķĪĄÕÅ»ĶāĮÕ░▒õĖŹÕ£©õ║å’╝īµł¢ĶĆģµø┤µ¢░õ║åŃĆéõ╗Ćõ╣łµŚČÕĆÖÕåŹńł¼Ķ┐ÖõĖ¬ńĮæń½ÖÕæó’╝¤ķĆÜÕĖĖÕ»╣õ║Äń╗ÅÕĖĖÕÅśÕī¢ńÜäńĮæķĪĄ’╝īĶ┐ÖõĖ¬ķŚ┤ķÜöµŚČķŚ┤Õ║öĶ»źń¤ŁõĖĆõ║øŃĆé

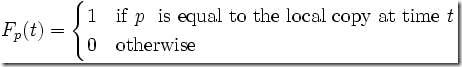

µ¢░ķ▓£Õ║”’╝ÜÕ£©õĖĆիܵŚČķŚ┤tÕåģ’╝īķĪĄķØ󵜻ÕÉ”µ£ēÕÅśÕī¢ŃĆé

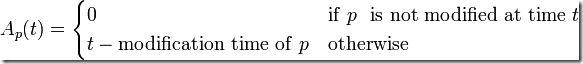

Age’╝Ü µ£¼Õ£░ńĮæķĪĄµŗĘĶ┤ص£ēÕżÜõ╣łĶ┐浌ČŃĆé

┬Ā

µ£ēõĖĆń¦ŹÕĖĖĶ¦üńÜäķćŹĶ«┐ķŚ«ńŁ¢ńĢźµś»’╝īÕģłõ╗źõĖĆõĖ¬ķ╗śĶ«żńÜäķóæÕ║”Ķ«┐ķŚ«ķĪĄķØó’╝īÕ”éµ×£ÕÅæńÄ░ķĪĄķØóµīüń╗ŁõĖŹµø┤µ¢░’╝īÕ░▒ķĆɵŁźķÖŹõĮÄĶ┐ÖõĖ¬ķóæÕ║”’╝øÕÅŹõ╣ŗõ║”ńäČŃĆé

ńż╝Ķ▓īµĆ¦ńŁ¢ńĢź

ńł¼ĶÖ½ÕĮōńäČÕÅ»õ╗źÕ░ĮÕÅ»ĶāĮÕ┐½Õ£░ńł¼ÕÅ¢µĢ░µŹ«’╝īõĮåµś»µłæõ╗¼ķ£ĆĶ”üĶĆāĶÖæńĮæń½ÖńÜäµĆ¦ĶāĮÕÄŗÕŖø’╝īÕĘ▓ń╗ÅÕ»╣ńĮæń╗£ĶĄäµ║ÉńÜäµČłĶĆŚŃĆé

µ£ēõĖĆõĖ¬robots exclusionÕŹÅĶ««’╝īµīćÕ«Üõ║åńł¼ĶÖ½Õ║öĶ»źµĆĵĀĘĶ«┐ķŚ«ńĮæń½ÖńÜäĶĄäµ║É’╝īÕō¬õ║øÕÅ»õ╗źĶ«┐ķŚ«’╝īÕō¬õ║øõĖŹÕÅ»õ╗źĶ«┐ķŚ«ŃĆéĶ┐ÖõĖ¬ÕŹÅĶ««Õ╣ČõĖŹµś»Õ╝║ÕłČńÜä’╝īõĮåµś»ÕĘ▓ń╗ŵś»õ║ŗÕ«×õĖŖńÜäµĀćÕćåŃĆéµ»öÕ”é’╝īCrawl-delayÕÅéµĢ░’╝īÕ░▒ÕÅ»õ╗źÕ«Üõ╣ēµ»ÅĶ┐×ń╗ŁõĖżµ¼ĪńÜäĶ»Ęµ▒é’╝īĶć│Õ░æķ£ĆĶ”üķŚ┤ķÜöÕżÜÕ░æń¦ÆŃĆé

õ╗źµ£¼ńĮæń½ÖńÜärobots.txtõĖ║õŠŗ’╝Ü

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/Sitemap:┬Āhttp://www.raychase.net/sitemap.xml.gz

ÕģČõĖŁńÜäUser-agentĶĪ©ńż║Õ»╣ńł¼ĶÖ½ń▒╗Õ×ŗµ▓Īµ£ēķÖÉÕłČ’╝īDisallowõĖżĶĪīµīćÕ«Üõ║åÕō¬õ║øURLµś»õĖŹÕģüĶ«ĖµÉ£ń┤óÕ╝ĢµōĵŖōÕÅ¢ńÜä’╝øSitemapÕłÖµś»õĖĆõĖ¬xmlµĀ╝Õ╝ÅńÜäńĮæń½ÖÕ£░ÕøŠ’╝Ü

|

1

2

3

4

5

6

7

8

9

10

11

12

|

<url>

┬Ā┬Ā<lastmod>2013-05-25T16:32:13+00:00</lastmod>

┬Ā┬Ā<changefreq>daily</changefreq>

┬Ā┬Ā<priority>1.0</priority>

</url>

<url>

┬Ā┬Ā<lastmod>2013-05-19T14:46:19+00:00</lastmod>

┬Ā┬Ā<changefreq>monthly</changefreq>

┬Ā┬Ā<priority>0.2</priority>

</url>

|

µīćÕ«Üõ║åńĮæń½Öµ£ēÕō¬õ║øķĪĄķØó’╝īµø┤µ¢░ķóæńÄćÕÆīµØāķćŹÕÉ䵜»ÕżÜÕ░æŃĆéÕ”éµ×£µ£ēõ║øķĪĄķØóµ▓Īµ£ēµśÄµśŠńÜäńø┤µÄźķōŠµÄźµŖĄĶŠŠ’╝īķĆÜĶ┐ćsitemapńÜäÕĮóÕ╝ÅÕÅ»õ╗źÕæŖń¤źńł¼ĶÖ½ÕÄ╗µŖōÕÅ¢ŃĆéÕ”éµ×£õĮĀÕŠłĶ«©ÕÄīµ¤ÉõĖ¬µÉ£ń┤óÕ╝ĢµōÄ’╝īõĮĀÕÅ»õ╗źĶ┐ÖµĀʵīćÕ«Ü’╝łµłæÕŬµś»õĖŠõŠŗĶĆīÕĘ▓’╝īńÖŠÕ║”ķÖżõ║åÕüćĶŹ»ÕüćÕ╣┐ÕæŖõŠĄµØāõ┐Īµü»ń«ĪÕłČõĖ╗Ķ¦éµĆ¦Ķ┐ćµ╗żõ╗źÕż¢õ╣¤µś»ÕüÜõ║åõĖĆõ║øÕźĮõ║ŗńÜä -_-~’╝ē’╝Ü

User-agent: Baiduspider

Disallow: /

ńĮæķĪĄµĘ▒Õ║”

ķĆÜÕĖĖ’╝īĶČŖµś»µĘ▒ńÜäķōŠµÄź’╝īķćŹĶ”üµĆ¦ĶČŖõĮÄ’╝īµĢ░ķćÅõ╣¤ĶČŖÕż¦ŃĆéÕ»╣õ║Äńł¼ĶÖ½µØźĶ»┤’╝īĶČŖµĘ▒ńÜäķōŠµÄźÕŠĆÕŠĆõ╗ĘÕĆ╝ĶČŖÕ░ÅŃĆéÕ£©Õż¦ÕżÜµĢ░µāģÕåĄõĖŗ’╝īµłæõ╗¼õĖŹķ£ĆĶ”üµēƵ£ēńÜäõ┐Īµü»’╝īĶ┐ÖµŚČÕĆÖķ£ĆĶ”üµÄ¦ÕłČÕÉłńÉåńÜäńĮæķĪĄµĘ▒Õ║”’╝īõ╗ĘÕĆ╝ķ½śńÜäńĮæń½ÖÕÅ»õ╗źµĘ▒Õ║”ķĆéÕĮōÕż¦õĖĆõ║øŃĆé

õ║ÆĶüöńĮæÕŹ│µĢ░µŹ«Õ║ō

õ╗źÕēŹµłæµøŠń╗Åõ╗ŗń╗ŹĶ┐ćYQL’╝īõĖĆń¦ŹÕāÅSQLµ¤źĶ»óµĢ░µŹ«Õ║ōõĖƵĀʵ¤źĶ»óõ║ÆĶüöńĮæńĮæķĪĄµĢ░µŹ«ńÜäĶ»ŁĶ©Ć’╝īõĮĀõ╣¤ÕÅ»õ╗źÕ£©Ķ┐ÖõĖ¬YQLµÄ¦ÕłČÕÅ░Ķć¬ÕĘ▒Ķ»ĢĶ»Ģ’╝Ü

|

1

|

select * from flickr.photos.search where text="Cat" and api_key="your key here" limit 10

|

Ķ┐Öµś»õĖĆõĖ¬ŌĆ£get 10 flickr ŌĆ£catŌĆØ photosŌĆØńÜäõŠŗÕŁÉŃĆé

ÕåŹµ»öÕ”é’╝Ü

|

1

|

select * from html where url="http://finance.yahoo.com/q?s=yhoo" and xpath='//div[@id="yfi_headlines"]/div[2]/ul/li/a'

|

Õ”éµ×£õĮĀń£ŗÕŠŚµćéXPATHĶĪ©ĶŠŠÕ╝ÅńÜäĶ»Ø’╝īĶ┐ÖõĖĆÕ«ÜÕŠłµĖģµźÜŃĆéÕ«āÕÅ»õ╗źõ╗źµÖ«ķĆÜHTTP APIńÜäµ¢╣Õ╝ŵÜ┤ķ£▓Õć║µØź’╝Ü

|

1

|

http://query.yahooapis.com/v1/public/yql?q=select%20*%20from%20html%20where%20url%3D%22http%3A%2F%2Ffinance.yahoo.com%2Fq%3Fs%3Dyhoo%22%20and%20xpath%3D'%2F%2Fdiv%5B%40id%3D%22yfi_headlines%22%5D%2Fdiv%5B2%5D%2Ful%2Fli%2Fa'&format=json&diagnostics=true&callback=cbfunc |

Õ£©ÕŠłÕżÜµāģÕåĄõĖŗ’╝īµłæõ╗¼ķ£ĆĶ”üńÜäÕ╣ČõĖŹµś»Õ«Įµ│øńÜäõ┐Īµü»’╝īĶĆīµś»µśÄńĪ«Õ£░ń¤źķüōĶć¬ÕĘ▒ķ£ĆĶ”üõ╗Ćõ╣łõ┐Īµü»’╝īĶŁ¼Õ”鵤ÉńĮæń½ÖµĆ╗µś»µśŠńż║Ķć¬ÕĘ▒Õģ│Õ┐āńÜäõ┐Īµü»’╝īķéŻõ╣łÕ░▒ÕÅ»õ╗źÕƤńö©Õ«āµØźÕ«ÜµŚČńł¼ÕÅ¢ńē╣Õ«ÜńÜäķĪĄķØó’╝łµ»öÕ”éµłæõ╗źÕēŹÕ╣▓Ķ┐ćĶ┐ÖµĀĘńÜäõ║ŗ’╝ÜõĖĆÕ£║NBAµ»öĶĄøń╗ōµØ¤õ║å’╝īµłæµ▓Īµ£ēń£ŗ’╝īõĮåµś»µłæÕŠłµā│Õ░ĮÕ┐½Õ£░ń£ŗÕł░µ»öĶĄøÕĮĢÕāÅ’╝īõ║ĵś»µ»ÅķÜöÕćĀÕłåķƤÕ░▒ÕÄ╗ńł¼ÕÅ¢õĖĆõĖ¬Ķ«║ÕØøµ»öĶĄøõĖŗĶĮĮńÜäÕĖ¢ÕŁÉµ▒ćµĆ╗ķĪĄķØó’╝īÕĮōŌĆ£ķ®¼Õł║ŌĆØķéŻõĖ¬Õģ│ķö«Ķ»ŹÕć║ńÄ░ńÜ䵌ČÕĆÖ’╝īµłæÕ░▒ÕÄ╗ń£ŗõĖĆõĖŗµś»õĖŹµś»µ£ēµ»öĶĄøõĖŗĶĮĮõ║åŃĆéÕĮōńäČ’╝īõĮĀÕÅ»õ╗źÕüÜÕŠŚµø┤ÕźĮ’╝īÕåÖõĖĆõĖ¬Ķäܵ£¼Ķ«®µĢ┤õĖ¬õĖŗĶĮĮĶ┐ćń©ŗĶć¬ÕŖ©Õī¢Õ«īµłÉ’╝īĶ┐ÖµĀĘõĮĀÕ░▒ÕÅ»õ╗źÕ«ēÕ┐āõĖŖńÅŁõ║å’╝īńŁēÕø×Õł░Õ«ČńÜ䵌ČÕĆÖ’╝īµ»öĶĄøÕĘ▓ń╗ÅõĖŗĶĮĮÕ«īµ»ĢńŁēõĮĀÕÄ╗ń£ŗõ║å’╝ēŃĆéńÄ░Õ£©Ķ┐ÖµĀĘńÜäõ║ŗµāģÕÅ»õ╗źķĆÜĶ┐ćõĖŖķØóńÜäHTTP APIķōŠµÄźµø┤µ¢╣õŠ┐Õ£░Õ«īµłÉõ║åŃĆé

Õ«īµłÉµĢ┤õĖ¬Ķ┐ćń©ŗõ╗źÕÉÄ’╝īõĮĀõĖĆÕ«Üõ╝ܵ£ēĶ┐ÖµĀĘńÜäõĮōõ╝Ü’╝īõ║ÆĶüöńĮæÕģČÕ«×Õ░▒µś»õĖĆõĖ¬ńĪĢÕż¦ńÜäµĢ░µŹ«Õ║ō’╝łõĖŹń«ĪURIńÜäÕ«Üõ╣ēµś»ÕÉ”ń¼”ÕÉłRESTfulķŻÄµĀ╝’╝īÕ«āµ£ĆÕżÜÕŬĶāĮĶ»┤µś»µĢ░µŹ«µś»õĖŹµś»ĶāĮÕż¤õ╗źń¼”ÕÉłµ¤Éń¦Źń╗¤õĖƵĀ╝Õ╝ÅńÜäµ¢╣Õ╝ÅµØźĶÄĘÕÅ¢’╝ēŃĆé

- HTMLŃĆüRSSŃĆüPDFŌĆ”ŌĆ”Ķ┐Öõ║øÕŬµś»õĖŹÕÉīńÜäµĢ░µŹ«µĀ╝Õ╝ÅĶĆīÕĘ▓’╝īÕÆīÕåģÕ«╣µŚĀÕģ│’╝īĶÄĘÕÅ¢Ķ┐Öõ║øõĖŹÕÉīµĀ╝Õ╝ÅõĖŹÕÉīÕ£░ÕØƵĢ░µŹ«ńÜäń╗äõ╗ČÕÅ»õ╗źÕŽÕüÜrequester’╝ø

- XPATHŃĆüCSSPathŌĆ”ŌĆ”Ķ┐Öõ║øµś»ķÆłÕ»╣õĖŹÕÉīµĢ░µŹ«’╝īÕÄ╗Ķ¦Żµ×ÉĶ┐Öõ║øµĢ░µŹ«’╝īµīćիܵ£ēńö©õ┐Īµü»ńÜäĶĘ»ÕŠäĶĪ©ĶŠŠÕ╝Å’╝īĶ¦Żµ×ÉĶ┐Öõ║øµĢ░µŹ«ńÜäń╗äõ╗ČĶó½ń¦░õĖ║parser’╝ø

- ÕŁśÕ驵»ÅõĖĆÕåģÕ«╣µØĪńø«õĮ┐ńö©Õō¬õĖ¬requesterÕÆīÕō¬õĖ¬parserńÜäķģŹńĮ«’╝īµ▒ćµĆ╗Õ£©õĖĆõĖ¬configurationńÜäń╗äõ╗ČÕåģ’╝ø

- ńÄ░Õ£©’╝īĶ┐śķ£ĆĶ”üõĖĆõĖ¬Ķ░āÕ║”ÕÖ©schedulerń«ĪńÉåĶŗźÕ╣▓õĖ¬ń║┐ń©ŗ’╝łµł¢Ķ┐øń©ŗ’╝ēµĀ╣µŹ«configurationÕÄ╗ńł¼ÕÅ¢µĢ░µŹ«õ║å’╝ø

- µĢ░µŹ«ńł¼ÕÅ¢Õ«īµłÉÕÉĵīüõ╣ģÕī¢Õł░ÕŁśÕé©ń╗äõ╗ČstorageõĖŁŃĆé

µ£ēõ║åõĖŖķØóĶ┐Ö5õĖ¬ń╗äõ╗Č’╝īõĖĆõĖ¬ńē╣Õ«Üõ┐Īµü»ńÜäńł¼ÕÅ¢ń©ŗÕ║ÅÕ░▒Õ«īµłÉõ║å’╝īÕÆīõĖĆõĖ¬õ╝Āń╗¤µäÅõ╣ēõĖŖńÜäńĮæń╗£ńł¼ĶÖ½ńøĖµ»ö’╝īÕ«āµø┤ÕŖĀń«ĆÕŹĢ’╝īõ╣¤õĖŹķ£ĆĶ”üĶ¦Żµ×ÉHTMLķōŠµÄźÕɽõ╣ēńÜäĶ┐ćń©ŗŃĆé

ÕÅ”Õż¢’╝īÕĆ╝ÕŠŚµ│©µäÅńÜ䵜»’╝īµ£ēµŚČÕĆÖńĮæń½Öõ╝ÜÕüÜÕÅŹńł¼ĶÖ½µ£║ÕłČ’╝īõĖÄÕģČÕÄ╗ńī£Õ«āÕÅŹńł¼ĶÖ½ńÜäĶ¦äÕłÖ’╝īĶ┐śõĖŹÕ”éķĆÜĶ┐ćĶäܵ£¼ÕÉ»ÕŖ©õĖĆõĖ¬µĄÅĶ¦łÕÖ©ÕÄ╗Ķ»Ęµ▒éķĪĄķØóŃĆéĶ┐śµ£ē’╝īķĪĄķØóõ╣ŗķŚ┤ńÜäÕģ│ĶüöÕģ│ń│╗µ£ēµŚČÕ╣ČõĖŹĶāĮÕż¤õ╗Ä<a href=ŌĆØxxxŌĆØ>Ķ┐ÖµĀĘńÜäķōŠµÄźõĖŁÕÅæńÄ░’╝īµ£ēµŚČµś»ķĆÜĶ┐ćJavaScriptńÜäAjaxĶ»Ęµ▒éńŁēńŁēÕ«×ńÄ░’╝īĶ┐Öń¦ŹµāģÕåĄõĖŗńÜäķōŠµÄźÕģ│ń│╗Õ»╣ńĮæń╗£ńł¼ĶÖ½Õ╣ČõĖŹÕÅŗÕźĮ’╝īõ╣¤ÕÅ»õ╗źķĆÜĶ┐ćÕÉ»ÕŖ©õĖĆõĖ¬ń£¤Õ«×ńÜ䵥ÅĶ¦łÕÖ©Ķ»Ęµ▒éÕÄ╗ĶÄĘÕÅ¢ŃĆé

Javaµ£ēÕÉŹńÜäÕ╝Ƶ║ÉńĮæń╗£ńł¼ĶÖ½Õīģµŗ¼HeritrixÕÆīNutch’╝īÕÉÄń╗ŁµłæÕåŹĶ»”ń╗åõ╗ŗń╗ŹõĖĆõĖŗŃĆé

µ¢ćń½Āń│╗µ£¼õ║║ÕÄ¤Õłø’╝īĶĮ¼ĶĮĮĶ»Ęõ┐صīüÕ«īµĢ┤µĆ¦Õ╣ȵ│©µśÄÕć║Ķć¬ŃĆŖÕøøńü½ńÜäÕöĀÕÅ©ŃĆŗ

ńøĖÕģ│µÄ©ĶŹÉ

Õ▒▒õĖ£Õ╗║ńŁæÕż¦ÕŁ”Ķ«Īń«Śµ£║ńĮæń╗£Ķ»Šń©ŗĶ«ŠĶ«ĪŃĆŖÕ¤║õ║ÄPythonńÜäńĮæń╗£ńł¼ĶÖ½Ķ«ŠĶ«ĪŃĆŗ.docxÕ▒▒õĖ£Õ╗║ńŁæÕż¦ÕŁ”Ķ«Īń«Śµ£║ńĮæń╗£Ķ»Šń©ŗĶ«ŠĶ«ĪŃĆŖÕ¤║õ║ÄPythonńÜäńĮæń╗£ńł¼ĶÖ½Ķ«ŠĶ«ĪŃĆŗ.docxÕ▒▒õĖ£Õ╗║ńŁæÕż¦ÕŁ”Ķ«Īń«Śµ£║ńĮæń╗£Ķ»Šń©ŗĶ«ŠĶ«ĪŃĆŖÕ¤║õ║ÄPythonńÜäńĮæń╗£ńł¼ĶÖ½Ķ«ŠĶ«ĪŃĆŗ.docxÕ▒▒õĖ£Õ╗║ńŁæ...

ńĮæń╗£ńł¼ĶÖ½ ńĮæń╗£ńł¼ĶÖ½ ńĮæń╗£ńł¼ĶÖ½ńĮæń╗£ńł¼ĶÖ½ńĮæń╗£ńł¼ĶÖ½ńĮæń╗£ńł¼ĶÖ½ńĮæń╗£ńł¼ĶÖ½ńĮæń╗£ńł¼ĶÖ½ńĮæń╗£ńł¼ĶÖ½ńĮæń╗£ńł¼ĶÖ½ńĮæń╗£ńł¼ĶÖ½ńĮæń╗£ńł¼ĶÖ½ńĮæń╗£ńł¼ĶÖ½

ŃĆŖPythonńĮæń╗£ńł¼ĶÖ½µŖƵ£»µĪłõŠŗµĢÖń©ŗŃĆŗPPTĶ»Šõ╗Č(Õģ▒10ÕŹĢÕģā)õĖāÕŹĢÕģāńł¼ÕÅ¢APPÕÆīPCÕ«óµłĘń½»µĢ░µŹ«.pdfŃĆŖPythonńĮæń╗£ńł¼ĶÖ½µŖƵ£»µĪłõŠŗµĢÖń©ŗŃĆŗPPTĶ»Šõ╗Č(Õģ▒10ÕŹĢÕģā)õĖāÕŹĢÕģāńł¼ÕÅ¢APPÕÆīPCÕ«óµłĘń½»µĢ░µŹ«.pdfŃĆŖPythonńĮæń╗£ńł¼ĶÖ½µŖƵ£»µĪłõŠŗµĢÖń©ŗŃĆŗPPTĶ»Šõ╗Č(Õģ▒10...

ńĮæń╗£ńł¼ĶÖ½õĮ£õĖÜń╗āõ╣Ā

µ£¼õ╣”õ╗ÄPythonńÜäÕ«ēĶŻģÕ╝ĆÕ¦ŗ’╝īĶ»”ń╗åĶ«▓Ķ¦Żõ║åPythonõ╗Äń«ĆÕŹĢń©ŗÕ║ÅÕ╗Čõ╝ĖÕł░PythonńĮæń╗£ńł¼ĶÖ½ńÜäÕģ©Ķ┐ćń©ŗŃĆéµ£¼õ╣”õ╗ÄÕ«×µłśÕć║ÕÅæ’╝īµĀ╣µŹ«õĖŹÕÉīńÜäķ£Ćµ▒éķĆēÕÅ¢õĖŹÕÉīńÜäńł¼ĶÖ½’╝īµ£ēķÆłÕ»╣µĆ¦Õ£░Ķ«▓Ķ¦Żõ║åÕćĀń¦ŹPythonńĮæń╗£ńł¼ĶÖ½ŃĆéµ£¼õ╣”Õģ▒8ń½Ā’╝īµČĄńø¢ńÜäÕåģÕ«╣µ£ēPythonĶ»ŁĶ©ĆńÜä...

PythonńĮæń╗£ńł¼ĶÖ½µŖƵ£» ń¼¼1ń½Ā Pythonńł¼ĶÖ½ńÄ»ÕóāõĖÄńł¼ĶÖ½ń«Ćõ╗ŗ µĢÖµĪł.pdfPythonńĮæń╗£ńł¼ĶÖ½µŖƵ£» ń¼¼1ń½Ā Pythonńł¼ĶÖ½ńÄ»ÕóāõĖÄńł¼ĶÖ½ń«Ćõ╗ŗ µĢÖµĪł.pdfPythonńĮæń╗£ńł¼ĶÖ½µŖƵ£» ń¼¼1ń½Ā Pythonńł¼ĶÖ½ńÄ»ÕóāõĖÄńł¼ĶÖ½ń«Ćõ╗ŗ µĢÖµĪł.pdfPythonńĮæń╗£ńł¼ĶÖ½µŖƵ£» ń¼¼1ń½Ā ...

ķĆéńö©õ║ÄĶ┐øĶĪīńĮæń╗£ńł¼ĶÖ½µ»ĢõĖÜĶ«ŠĶ«ĪńÜäÕÉīÕŁ”’╝īÕģ│õ║ÄńĮæń╗£ńł¼ĶÖ½Ķ«║µ¢ćńŁöĶŠ®PPT ...

ńĮæń╗£ńł¼ĶÖ½Ķ«║µ¢ćńŁöĶŠ®’╝īńĮæń╗£ńł¼ĶÖ½Ķ«║µ¢ćńŁöĶŠ®Ķ»Šõ╗Č’╝īńĮæń╗£ńł¼ĶÖ½Ķ«║µ¢ćńŁöĶŠ®PPT

PythonńĮæń╗£ńł¼ĶÖ½ÕĘźń©ŗÕĖłń│╗ÕłŚÕ¤╣Ķ«ŁĶ»Šń©ŗ(Õģ©ÕźŚĶ»”ń╗åńēł).docxPythonńĮæń╗£ńł¼ĶÖ½ÕĘźń©ŗÕĖłń│╗ÕłŚÕ¤╣Ķ«ŁĶ»Šń©ŗ(Õģ©ÕźŚĶ»”ń╗åńēł).docxPythonńĮæń╗£ńł¼ĶÖ½ÕĘźń©ŗÕĖłń│╗ÕłŚÕ¤╣Ķ«ŁĶ»Šń©ŗ(Õģ©ÕźŚĶ»”ń╗åńēł).docxPythonńĮæń╗£ńł¼ĶÖ½ÕĘźń©ŗÕĖłń│╗ÕłŚÕ¤╣Ķ«ŁĶ»Šń©ŗ(Õģ©ÕźŚĶ»”ń╗åńēł)....

ŃĆŖńö©PythonÕåÖńĮæń╗£ńł¼ĶÖ½ŃĆŗĶ«▓Ķ¦Żõ║åÕ”éõĮĢõĮ┐ńö©PythonµØźń╝¢ÕåÖńĮæń╗£ńł¼ĶÖ½ń©ŗÕ║Å’╝īÕåģÕ«╣Õīģµŗ¼ńĮæń╗£ńł¼ĶÖ½ń«Ćõ╗ŗ’╝īõ╗ÄķĪĄķØóõĖŁµŖōÕÅ¢µĢ░µŹ«ńÜäõĖēń¦Źµ¢╣µ│Ģ’╝īµÅÉÕÅ¢ń╝ōÕŁśõĖŁńÜäµĢ░µŹ«’╝īõĮ┐ńö©ÕżÜõĖ¬ń║┐ń©ŗÕÆīĶ┐øń©ŗµØźĶ┐øĶĪīÕ╣ČÕÅæµŖōÕÅ¢’╝īÕ”éõĮĢµŖōÕÅ¢ÕŖ©µĆüķĪĄķØóõĖŁńÜäÕåģÕ«╣’╝īõĖÄĶĪ©ÕŹĢĶ┐øĶĪī...

ńĮæń╗£ńł¼ĶÖ½’╝łÕÅłń¦░õĖ║ńĮæķĪĄĶ£śĶøø’╝īńĮæń╗£µ£║ÕÖ©õ║║’╝īÕ£©FOAFńżŠÕī║õĖŁķŚ┤’╝īµø┤ń╗ÅÕĖĖńÜäń¦░õĖ║ńĮæķĪĄĶ┐ĮķĆÉĶĆģ’╝ē’╝īµś»õĖĆń¦Źµīēńģ¦õĖĆÕ«ÜńÜäĶ¦äÕłÖ’╝īĶć¬ÕŖ©Õ£░µŖōÕÅ¢õĖćń╗┤ńĮæõ┐Īµü»ńÜäń©ŗÕ║ŵł¢ĶĆģĶäܵ£¼ŃĆéÕÅ”Õż¢õĖĆõ║øõĖŹÕĖĖõĮ┐ńö©ńÜäÕÉŹÕŁŚĶ┐śµ£ēĶÜéĶÜüŃĆüĶć¬ÕŖ©ń┤óÕ╝ĢŃĆüµ©Īµŗ¤ń©ŗÕ║ŵł¢ĶĆģĶĀĢĶÖ½ŃĆé

PythonńĮæń╗£ńł¼ĶÖ½µŖƵ£» Õ«īµĢ┤µĢÖµĪł.docxPythonńĮæń╗£ńł¼ĶÖ½µŖƵ£» Õ«īµĢ┤µĢÖµĪł.docxPythonńĮæń╗£ńł¼ĶÖ½µŖƵ£» Õ«īµĢ┤µĢÖµĪł.docxPythonńĮæń╗£ńł¼ĶÖ½µŖƵ£» Õ«īµĢ┤µĢÖµĪł.docxPythonńĮæń╗£ńł¼ĶÖ½µŖƵ£» Õ«īµĢ┤µĢÖµĪł.docxPythonńĮæń╗£ńł¼ĶÖ½µŖƵ£» Õ«īµĢ┤µĢÖµĪł.docxPython...

ńĮæń╗£ńł¼ĶÖ½µ║ÉńĀüńĮæń╗£ńł¼ĶÖ½µ║ÉńĀüńĮæń╗£ńł¼ĶÖ½µ║ÉńĀüńĮæń╗£ńł¼ĶÖ½µ║ÉńĀüńĮæń╗£ńł¼ĶÖ½µ║ÉńĀüńĮæń╗£ńł¼ĶÖ½µ║ÉńĀüńĮæń╗£ńł¼ĶÖ½µ║ÉńĀüńĮæń╗£ńł¼ĶÖ½µ║ÉńĀüńĮæń╗£ńł¼ĶÖ½µ║ÉńĀü

PythonńĮæń╗£ńł¼ĶÖ½Õ«×õ╣ĀµŖźÕæŖ.pdfPythonńĮæń╗£ńł¼ĶÖ½Õ«×õ╣ĀµŖźÕæŖ.pdfPythonńĮæń╗£ńł¼ĶÖ½Õ«×õ╣ĀµŖźÕæŖ.pdfPythonńĮæń╗£ńł¼ĶÖ½Õ«×õ╣ĀµŖźÕæŖ.pdfPythonńĮæń╗£ńł¼ĶÖ½Õ«×õ╣ĀµŖźÕæŖ.pdfPythonńĮæń╗£ńł¼ĶÖ½Õ«×õ╣ĀµŖźÕæŖ.pdfPythonńĮæń╗£ńł¼ĶÖ½Õ«×õ╣ĀµŖźÕæŖ.pdfPythonńĮæń╗£ńł¼ĶÖ½Õ«×õ╣Ā...

ńĮæń╗£ńł¼ĶÖ½µŖƵ£» ńł¼ĶÖ½µŖƵ£»ńĮæń╗£ńł¼ĶÖ½µŖƵ£» ńł¼ĶÖ½µŖƵ£»ńĮæń╗£ńł¼ĶÖ½µŖƵ£» ńł¼ĶÖ½µŖƵ£»ńĮæń╗£ńł¼ĶÖ½µŖƵ£» ńł¼ĶÖ½µŖƵ£»ńĮæń╗£ńł¼ĶÖ½µŖƵ£» ńł¼ĶÖ½µŖƵ£»ńĮæń╗£ńł¼ĶÖ½µŖƵ£» ńł¼ĶÖ½µŖƵ£»ńĮæń╗£ńł¼ĶÖ½µŖƵ£» ńł¼ĶÖ½µŖƵ£»ńĮæń╗£ńł¼ĶÖ½µŖƵ£» ńł¼ĶÖ½µŖƵ£»ńĮæń╗£ńł¼ĶÖ½µŖƵ£» ńł¼ĶÖ½µŖƵ£»ńĮæń╗£ńł¼ĶÖ½...

ńĮæń╗£ńł¼ĶÖ½ javaõ╗ŻńĀüń«ĆÕŹĢÕ«×ńÄ░ŃĆéÕÅ»õ╗źõŠøõĮĀÕÅéĶĆāÕō”ŃĆéĶāĮńø┤µÄźÕ»╝ÕģźÕĘźń©ŗĶ┐ÉĶĪīńÜäÕō” ńĮæń╗£ńł¼ĶÖ½ javaõ╗ŻńĀüń«ĆÕŹĢÕ«×ńÄ░ŃĆéÕÅ»õ╗źõŠøõĮĀÕÅéĶĆāÕō”ŃĆéĶāĮńø┤µÄźÕ»╝ÕģźÕĘźń©ŗĶ┐ÉĶĪīńÜäÕō”

ÕŹŚÕ╝ĆÕż¦ÕŁ”20µśźÕŁ”µ£¤(1709ŃĆü1803ŃĆü1809ŃĆü1903ŃĆü1909ŃĆü2003)ŃĆŖńĮæń╗£ńł¼ĶÖ½õĖÄõ┐Īµü»µÅÉÕÅ¢ŃĆŗÕ£©ń║┐õĮ£õĖÜÕÅéĶĆāńŁöµĪł.pdfÕŹŚÕ╝ĆÕż¦ÕŁ”20µśźÕŁ”µ£¤(1709ŃĆü1803ŃĆü1809ŃĆü1903ŃĆü1909ŃĆü2003)ŃĆŖńĮæń╗£ńł¼ĶÖ½õĖÄõ┐Īµü»µÅÉÕÅ¢ŃĆŗÕ£©ń║┐õĮ£õĖÜÕÅéĶĆāńŁöµĪł.pdfÕŹŚÕ╝ĆÕż¦ÕŁ”20µśź...

Õ╝ĆÕÅæõĖĆõĖ¬µ»öĶŠāÕ«īÕ¢äńÜäÕ¤║õ║ÄJavaWebńÜäńĮæń╗£ńł¼ĶÖ½ń│╗ń╗¤’╝īń«ĆÕŹĢµØźĶ»┤’╝īÕ░▒µś»õĖĆõĖ¬ÕÅ»õ╗źõ╗ĵīćÕ«ÜńĮæń½Öńł¼ÕÅ¢µĢ░µŹ«ńÜäń│╗ń╗¤’╝īķĆÜĶ┐ćÕÉ»ÕŖ©Õ«óµłĘń½»’╝īÕÅ»õ╗źÕ«×ńÄ░õ╗źõĖŗÕŖ¤ĶāĮ’╝Ü 1ŃĆüńł¼ÕÅ¢µĢ░µŹ«: µ£¼µ¼Īńł¼ÕÅ¢µĢ░µŹ«ńÜäµØźµ║ÉBOSSńø┤Ķüś’╝īÕ£©ĶüīõĮŹĶŠōÕģźµĪåķćīķØóĶŠōÕģźõĮĀµā│Ķ”üµ¤źĶ»ó...

PythonńĮæń╗£ńł¼ĶÖ½µŖƵ£»-µĢÖÕŁ”Õż¦ń║▓.pdfPythonńĮæń╗£ńł¼ĶÖ½µŖƵ£»-µĢÖÕŁ”Õż¦ń║▓.pdfPythonńĮæń╗£ńł¼ĶÖ½µŖƵ£»-µĢÖÕŁ”Õż¦ń║▓.pdfPythonńĮæń╗£ńł¼ĶÖ½µŖƵ£»-µĢÖÕŁ”Õż¦ń║▓.pdfPythonńĮæń╗£ńł¼ĶÖ½µŖƵ£»-µĢÖÕŁ”Õż¦ń║▓.pdfPythonńĮæń╗£ńł¼ĶÖ½µŖƵ£»-µĢÖÕŁ”Õż¦ń║▓.pdfPythonńĮæń╗£ńł¼ĶÖ½...

µ£¼õ╣”Ķ«▓Ķ¦Ż õ║å Õ”éõĮĢõĮ┐ńö©PÕĘØlOilµØźń╝¢ÕåÖ ńĮæń╗£ńł¼ĶÖ½ń©ŗÕ║Å ’╝ī Õåģ Õ«╣Õīģµŗ¼ ńĮæń╗£ńł¼ĶÖ½ń«Ćõ╗ŗ ’╝ī õ╗ÄķĪĄķØó õĖŁ µŖōÕÅ¢µĢ░µŹ« ńÜäõĖēń¦Źµ¢╣µ│Ģ ’╝ī µÅÉÕÅ¢ń╝ōÕŁś õĖŁ ńÜä µĢ░µŹ« ’╝ī õĮ┐ńö© ÕżÜ õĖ¬ń║┐ń©ŗÕÆīĶ┐øń©ŗµØźĶ┐øĶĪīÕ╣ČÕÅæµŖōÕÅ¢ ’╝ī Õ”éõĮĢµŖōÕÅ¢ÕŖ©µĆüķĪĄķØó õĖŁ ńÜä Õåģ Õ«╣ ...